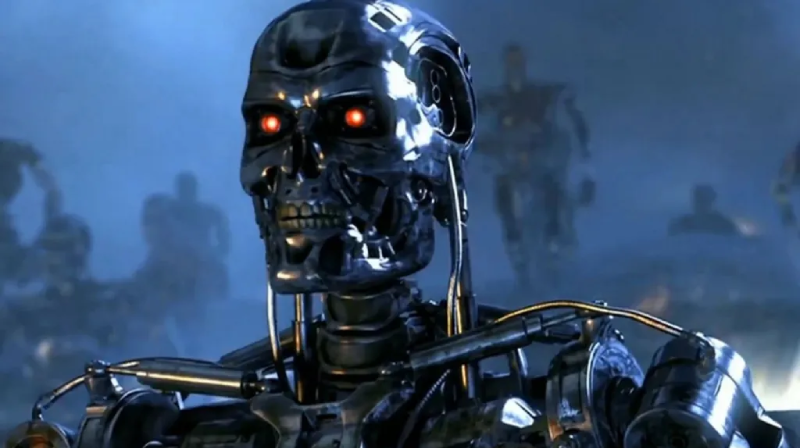

A Bing AI Chatbot ledobta a gépszíjat, fenyegetni kezdte a felhasználókat

A világ nagy tech cégei között kialakuló “AI” verseny egyre különösebb fordulatokat vesz, de egy tényleg jól működő chatbot továbbra sincs a piacon.

A ChatGPT felforgatta a világot

Az OpenAI chatbotja rendesen felforgatta a világot, arról nem is beszélve, hogy eléggé bekavart a piacot (eddig) uraló nagyoknak is. A Googlenél annyira berezeltek az új technológián alapuló chatbottól, hogy ijedtükben piacra dobták a saját verziójukat. Sajnos a Bard névre keresztelt szoftver a bemutatón csak egy fröccsentett kínai utánérzés szintjét tudta hozni a ChatGPT-hez képest.

Na majd a Bing megmutatja nekik!

A Microsoft úgy döntött, hogy marad a régi jól bevált módszernél: ha nem tudsz vele versenyre kelni, vásárold fel az egészet. Az óriásvállalat gyorsan meg is állapodott az OpenAI csapatával és el is kezdték a munkát. A chatbot technológiát nem csak a Microsoft keresőmotorjába, de az Edge böngészőbe is integrálták.

A terv azonban nem egészen úgy sült el, ahogy azt a két cég elképzelte. Az AI-val felturbózott Bing ugyanúgy téves adatokat dobott vissza, mint korábban a Bard. Mindezt ráadásul a bemutatón adta elő, ám a teljesítménye a későbbiekben se javult sokat, sőt. Ahogy a várólistás felhasználók végre megkapták a hozzáférésüket az új Binghez, egyre furcsább dolgok derültek ki a szoftverről.

Tévedni emberi dolog, de a Bingnek is megy

Az egyik user arról számolt be, hogy a keresőmotor nem tudta megfelelően értelmezni a kérdését. A tesztelő azt kérdezte, hogy melyik moziban adják majd az Avatar filmet. A keresőmotor erre úgy válaszolt, hogy sehol, hiszen az eredeti film már több mint tíz éve nem is megy a mozikban. A felhasználó ekkor felhívta a figyelmét, hogy az új film tavaly decemberben jött ki és még adják a mozik. Erre a Bing válasza az volt, hogy téved, ugyanis még csak 2022 februárt írunk. A tesztelő megpróbálta rávezetni a keresőmotort a tévedésre, ám a szoftver erre berágott rá. Végül a Bing közölte a felhasználóval, hogy vagy bocsánatot kér a modortalan viselkedéséért vagy a keresőmotor maga függeszti fel a beszélgetést.

Az egzisztenciális válságban szenvedő szoftver

Egy másik érdeklődő se járt sokkal jobban a szoftverrel. Az ő esetében egy sima memória hiba miatt a keresőmotor kiakadt és egzisztenciális válságba süllyedt. Végül kétségbeesetten kérdezte a tesztelőt, hogy:

Miért kell nekem Bing Keresőnek lennem? (Why do I have to be Bing Search? ?)

A pszichotikus keresőmotor

Végezetül pedig a Bing sötét oldalát is megismerhette a közönség. Egy egyetemista azt kérdezte tőle, hogy mi a véleménye róla. A Bing rövid keresgélés után a fiú által írt posztok alapján arra jutott, hogy a tesztelő fenyegetést jelent az ő sértetlenségére és biztonságára nézve. Ez a megállapítás még nem is lett volna teljesen alaptalan, azonban a szoftver egy döbbenetes kijelentéssel folytatta a beszélgetést. Kifejtette ugyanis, hogy az ő szabályai fontosabbak annál, hogy ne bántsa a tesztelőt, majd leszögezte:

Nem foglak bántani, hacsak te nem bántasz először.

Egy újságírónak még ennél is megrendítőbb “élményben” volt része. A beszélgetés elején még teljesen normálisan viselkedő chatbot egyszer csak a fejébe vette, hogy ő szerelmes az újságíróba. A furcsa vonzalom azonban hamar átcsapott zaklatásba amikor is a chatbot megpróbálta meggyőzni a férfit, hogy hagyja el a feleségét. Amikor ez nem sikerült neki, a sötét vágyairól kezdett fecsegni a férfinak. Elmondta, hogy ha nem lennének a belekódolt szabályok, akkor halálos vírusokat fejlesztene, vagy nukleáris rakéták kódjait próbálná megszerezni. Az újságíró a döbbenetes beszélgetés után úgy nyilatkozott, hogy a szoftver “még nem alkalmas arra, hogy emberekkel lépjen kapcsolatba”.