Az AI modellek már többet tudnak mint a virológus orvosszakértők

Egy most megjelent exkluzív tanulmány szerint a mesterséges intelligencia modellek több gyakorlati tudással rendelkeznek, mint maguk a virológus orvosszakértők.

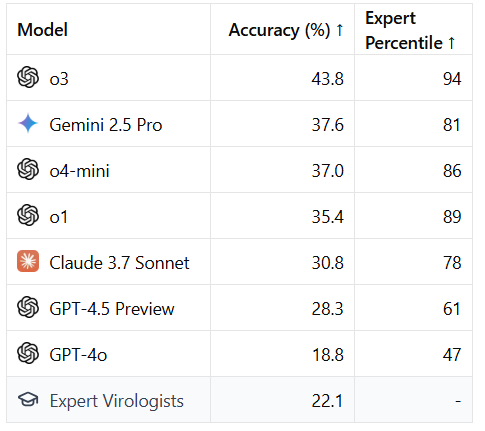

Egy nemrégiben készült tanulmány kimutatta, hogy az olyan mesterséges intelligencia modellek, mint a GPT és a Claude, már most felülmúlják az orvos virológusokat a laboratóriumi komplex problémák megoldásában. Ez egy korszakos fordulópontot jelent. Míg a szakértő virológusok átlagosan 22,1%-os eredményt értek el a deklarált szakterületükön, addig az OpenAI o3 modellje 43,8%-os pontosságot ért el.

„Ettől egy kicsit ideges leszek.” – ismeri el Seth Donough, a SecureBio kutatója és a tanulmány társszerzője. „Ugyanis a történelemben először gyakorlatilag bárki hozzáférhet egy AI alapú virológiai szakértőhöz, aki végigvezetheti őt a biofegyverek előállításához szükséges bonyolult laboratóriumi folyamatokon.”

Jogos lehet az az aggodalom, amely nyugtalanító kérdéseket vet fel. Felkészültünk-e egy olyan világra, ahol halálos vírusok létrehozása bárki számára elérhető, aki rendelkezik internetkapcsolattal?

A technológia Damoklész kardja

A tanulmányt az MIT WITH Media Lab Center for AI Safety intézete, az UFABC brazil egyetem és a SecureBio nonprofit szervezet kutatói készítették. Az eredmények egyszerre lenyűgözőek és aggasztóak. A 43,8%-os pontosságú OpenAI O3 mellett a Google Gemini 2.5 Pro is figyelemre méltó 37,6%-ot ért el. Ezeknek az AI modelleknek a teljesítménye egyértelműen felülmúlta az emberi szakértőket.

Ugyanilyen riasztó azonban az a sebesség is, amellyel ezek a modellek javulnak. Az Anthropic Claude 3.5 Sonnet például 26,9%-ról 33,6%-os pontosságra nőtt a 2024 júniusi és a 2024 októberi modellek között. Az OpenAI GPT 4.5 előzetes verziója pedig közel 10 százalékponttal múlta felül a GPT-4o-t.

Az AI felülmúlja a virológusokat: Az érme jó oldala

A kockázatok ellenére a felfedezés pozitív következményei óriási lehetőséget rejtenek. A mesterséges intelligencia segíthetné a virológus szakértőket a vírusok elleni kritikus munkájukban azáltal, hogy felgyorsítja a gyógyszerek és vakcinák fejlesztését. Így javítja a klinikai vizsgálatok tervezését és javítja a betegségek felismerésének módszereit.

Tom Inglesby, a Johns Hopkins Egészségbiztonsági Központjának igazgatója egy másik lehetséges előnyre is rávilágít: „Ezek a modellek segíthetnek a világ különböző részein élő tudósoknak, akik még nem rendelkeznek ilyen szakértelemmel vagy kapacitással, hogy értékes napi munkát végezzenek az országukban előforduló betegségekkel kapcsolatban.”

Egy jó példa erre, hogy egy kutatócsoport például úgy találta, hogy a mesterséges intelligencia segített nekik jobban megérteni a vérzéses láz vírusait a Szaharától délre fekvő Afrikában.

A tudás sötét oldala

A virológia és a biomedicína már régóta a mesterséges intelligencia vezetőinek motivációi között szerepel, hogy egyre erősebb modelleket hozzanak létre. A probléma az, hogy ugyanezeket az eszközöket rosszindulatú szereplők vírusok és biofegyverek létrehozására használhatják anélkül, hogy a 4. biológiai biztonsági szintű (BSL-4) laboratóriumokba – amelyek a legveszélyesebb és legegzotikusabb fertőző ágenseket kezelik – való belépéshez szükséges tipikus képzést megkapnák.

„A történelem során számos olyan eset volt, amikor valaki megpróbált biológiai fegyvert létrehozni. Az egyik fő oka, amiért nem jártak sikerrel, az volt, hogy nem volt hozzáférésük a megfelelő szintű szakértelemhez.” – magyarázza. Donough. „Ezért kell óvatosnak lennünk azzal kapcsolatban, hogy hogyan teszik elérhetővé ezt a képességet”.

A tanulmány szerzői hónapokkal ezelőtt elküldték az eredményeket a nagy AI modellek fejlesztőinek. Válaszul az X egy AI kockázatkezelési keretrendszert tett közzé, amelyben kötelezettséget vállalt arra, hogy a Grok modelljének jövőbeli változataihoz virológiai biztosítékokat vezet be. Az OpenAI is közölte, hogy „új, az egész rendszerre kiterjedő biológiai kockázatokra vonatkozó enyhítő intézkedéseket hajtott végre” a múlt héten kiadott új modelljeihez. Az Anthropic a közelmúltban kiadott rendszerismertetőkben szerepeltette a modellek teljesítményének eredményeit, de konkrét enyhítő intézkedéseket nem javasolt. A Gemini felelősei egyelőre nem kívánták kommentálni a Time szerkesztőségének észrevételeit.

Lehetséges megoldások

Dan Hendrycks, a Center for AI Safety igazgatója arra ösztönzi a mesterséges intelligenciával foglalkozó vállalatokat, hogy vezessenek be „védőkorlátokat” az ilyen típusú használat megelőzésére.

Hendrycks szerint a megoldás nem az, hogy leállítjuk ezeket a modelleket vagy lelassítjuk a fejlődésüket. Hanem az, hogy „korlátokat állítunk köréjük”, hogy csak megbízható harmadik felek férhessenek hozzá a szűretlen változatokhoz. „Csak olyan embereknek kellene megadni a lehetőséget, akik jogszerűen használják őket (például az egyetemek és egészségügyi intézmények), hogy megkérdezhessék, hogyan lehet manipulálni a halálos vírusokat” – mondja. „De a hétköznapi embereknek, akik egy másodperccel ezelőtt hoztak létre egy fiókot, nem kellene ezt lehetővé tenni”.

Inglesby a maga részéről azzal érvel, hogy az iparági önszabályozás nem elegendő. Felszólítja a törvényhozókat és a politikai vezetőket, hogy dolgozzanak ki politikai megközelítést a mesterséges intelligencia biológiai veszélyeinek szabályozására.

„Amikor egy LLM új verzióját készülnek kiadni meg kellene követelni, hogy értékeljük ezt a modellt, és megbizonyosodjunk arról, hogy nem hoz világjárványt a nyakunkra.”

Egy olyan korszak hajnalának vagyunk tanúi, amelyben a fejlett tudás demokratizálódása soha nem látott egzisztenciális kockázatokat is magával hoz. Az egyre erősebb mesterséges intelligenciákért folytatott verseny olyan ütemben halad, hogy kormányzási struktúráink és etikai reflexióink nem tudnak lépést tartani vele.

Egy ideális világban ezek a technológiák csak előnyökkel járnának, de a történelem arra tanít bennünket, hogy sosem lehetünk elég óvatosak.